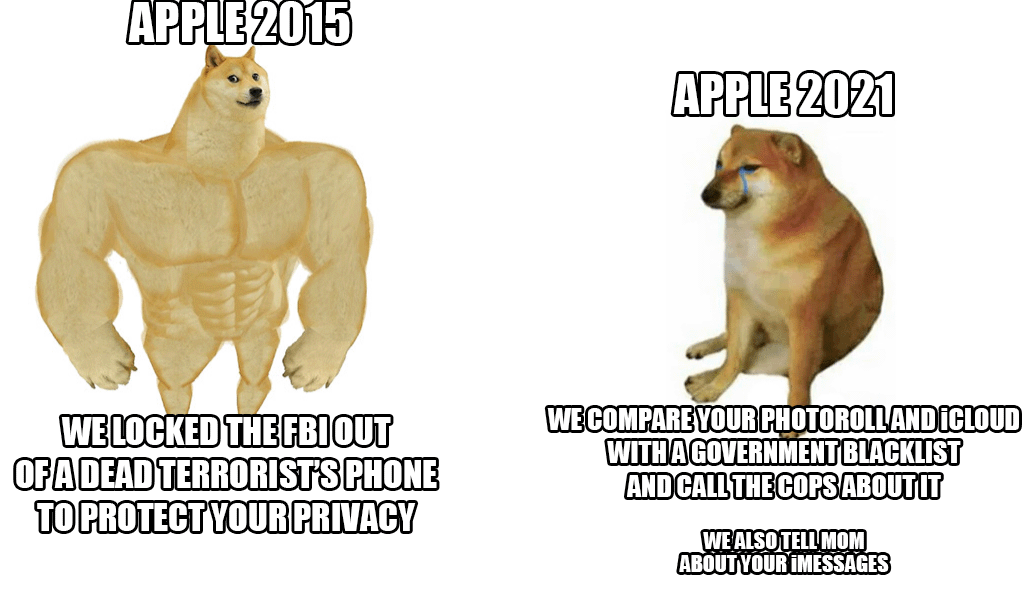

I slutet av förra veckan presenterade Apple ett nytt anti-barnmisshandelssystem som kommer att skanna nästan allas iCloud-bilder. Även om idén låter bra vid första anblicken, eftersom barn verkligen behöver skyddas från denna handling, kritiserades Cupertino-jätten ändå av en lavin – inte bara från användare och säkerhetsexperter, utan också från de anställdas led.

Enligt de senaste uppgifterna från en respekterad byrå Reuters ett antal anställda uttryckte sin oro över detta system i en intern kommunikation på Slack. De ska påstås vara rädda för eventuella övergrepp från myndigheter och regeringar, som skulle kunna missbruka dessa möjligheter, till exempel för att censurera personer eller utvalda grupper. Avslöjandet av systemet väckte en stark debatt, som redan har över 800 enskilda meddelanden inom ovannämnda Slack. Kort sagt, anställda är oroliga. Även säkerhetsexperter har tidigare uppmärksammat att det i fel händer skulle vara ett riktigt farligt vapen som används för att undertrycka aktivister, deras nämnda censur och liknande.

De goda nyheterna (hittills) är att nyheten bara kommer att börja i USA. För närvarande är det inte ens klart om systemet kommer att användas även inom EU:s stater. Men trots all kritik står Apple för sig själv och försvarar systemet. Han hävdar framför allt att all kontroll sker inom enheten och när det väl finns en matchning, då först i det ögonblicket kontrolleras ärendet igen av en Apple-anställd. Endast efter eget gottfinnande kommer det att överlämnas till berörda myndigheter.

Det kan vara intresserar dig

Jag skulle hata att byta från iCloud till något säkert och verkligt privat, men om Apple insisterar kommer jag att sluta betala dem ändå.

Den kommer att vara aktiv (för närvarande) endast i USA

Det spelar egentligen ingen roll var det kommer att gälla lagstiftningsmässigt. Den tekniken kommer redan att finnas där ute och distribueras. Det är den största risken.