De senaste åren har mobiltelefonernas värld sett enorma förändringar. Vi kan se grundläggande skillnader i praktiskt taget alla aspekter, oavsett om vi fokuserar på storlek eller design, prestanda eller andra smarta funktioner. Kvaliteten på kameror spelar för närvarande en relativt viktig roll. För tillfället kan vi säga att detta är en av de viktigaste aspekterna av smartphones, där flaggskeppen ständigt konkurrerar. När vi dessutom jämför exempelvis Android-telefoner med Apples iPhone hittar vi en rad intressanta skillnader.

Det kan vara intresserar dig

Om du är intresserad av den mobila teknikens värld så vet du säkert att en av de största skillnaderna kan hittas när det gäller sensorupplösning. Medan Android ofta erbjuder ett objektiv med mer än 50 Mpx, har iPhone satsat på endast 12 Mpx i flera år och kan fortfarande erbjuda bättre kvalitet på bilder. Däremot ägnas inte mycket uppmärksamhet åt bildfokuseringssystem, där vi möter en ganska intressant skillnad. Konkurrerande telefoner med operativsystemet Android förlitar sig ofta (delvis) på den så kallade laserautofokusen, medan smartphones med det bitna äpplets logotyp inte har denna teknik. Hur fungerar det egentligen, varför används det och vilka tekniker förlitar sig Apple på?

Laserfokus vs iPhone

Den nämnda laserfokuseringstekniken fungerar ganska enkelt och dess användning är mycket vettig. I det här fallet är en diod gömd i fotomodulen som avger strålning när avtryckaren trycks in. I detta fall skickas en stråle ut, som studsar av det fotograferade motivet/objektet och återkommer, vilken tid kan användas för att snabbt beräkna avståndet genom mjukvarualgoritmer. Tyvärr har den också sin mörka sida. När du tar bilder på större avstånd är laserfokusen inte längre lika exakt, eller när du tar bilder av genomskinliga föremål och ogynnsamma hinder som inte kan reflektera strålen på ett tillförlitligt sätt. Av denna anledning förlitar sig de flesta telefoner fortfarande på den åldersbeprövade algoritmen för att upptäcka scenens kontrast. En sensor med en sådan kan hitta den perfekta bilden. Kombinationen fungerar mycket bra och säkerställer snabb och exakt bildfokusering. Till exempel har den populära Google Pixel 6 detta system (LDAF).

Å andra sidan har vi iPhonen som fungerar lite annorlunda. Men i kärnan är det ganska likt. När du trycker på avtryckaren spelar ISP- eller Image Signal Processor-komponenten, som har förbättrats avsevärt de senaste åren, en nyckelroll. Detta chip kan använda kontrastmetoden och sofistikerade algoritmer för att omedelbart utvärdera bästa fokus och ta ett högkvalitativt foto. Baserat på erhållen data är det givetvis nödvändigt att mekaniskt flytta linsen till önskat läge, men alla kameror i mobiltelefoner fungerar på samma sätt. Även om de styrs av en "motor", är deras rörelse inte roterande, utan linjär.

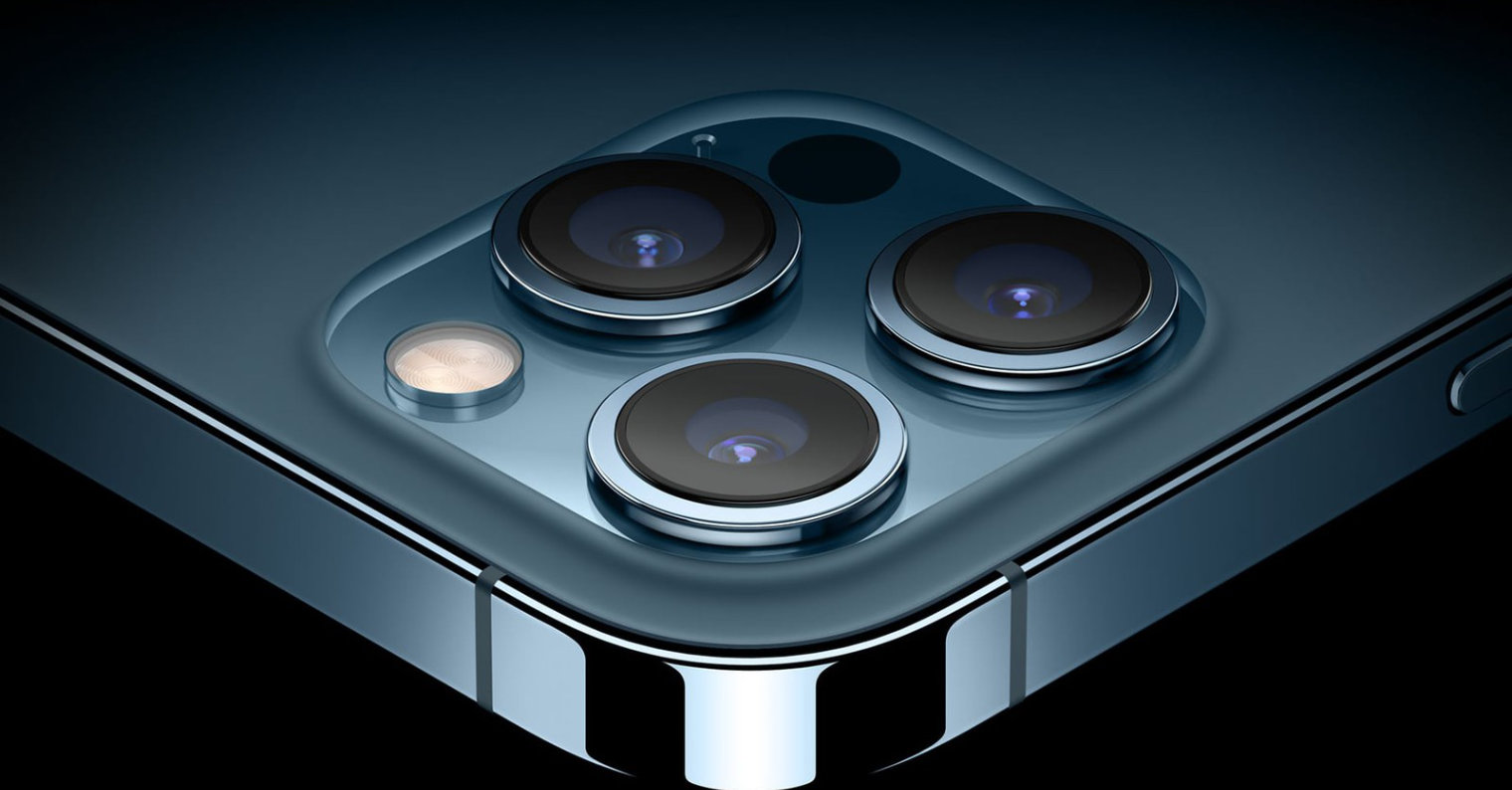

Ett steg före är modellerna iPhone 12 Pro (Max) och iPhone 13 Pro (Max). Som du kanske har gissat är dessa modeller utrustade med en så kallad LiDAR-skanner, som omedelbart kan bestämma avståndet från det fotograferade motivet och använda denna kunskap till sin fördel. Faktum är att denna teknik ligger nära det nämnda laserfokuset. LiDAR kan använda laserstrålar för att skapa en 3D-modell av sin omgivning, varför den främst används för att skanna rum, i autonoma fordon och för att ta bilder, främst porträtt.

Det kan vara intresserar dig

Adam Kos

Adam Kos

Flyger jorden runt med Apple

Flyger jorden runt med Apple